NVIDIA NIM APIs 最近悄悄开放了两个最新的国产大模型:GLM-4.7 和 MiniMax-M2.1。

虽然这两个模型暂时没有在 NVIDIA Build 官方模型广场页面列出,但实测已经可以正常使用了。如果你有 NVIDIA API Key,现在就可以免费体验。

模型信息

| 模型 | 模型名称 | 速度(实测) |

|---|---|---|

| GLM-4.7 | z-ai/glm4.7 |

~25 tokens/s |

| MiniMax-M2.1 | minimaxai/minimax-m2.1 |

~150 tokens/s |

API 地址:https://integrate.api.nvidia.com/v1

因为才刚开始免费提供这些最新模型,资源紧张,速度可能会有波动。

调用示例

cURL 请求

1 | curl --request POST \ |

将 model 改为 z-ai/glm4.7 即可调用 GLM-4.7 模型。

Python 调用(OpenAI SDK 兼容)

1 | from openai import OpenAI |

使用体验

- GLM-4.7:在日常 Coding 场景下表现很强,能力不输 Claude,值得一试

- MiniMax-M2.1:速度快(150 tokens/s),适合需要快速响应的场景

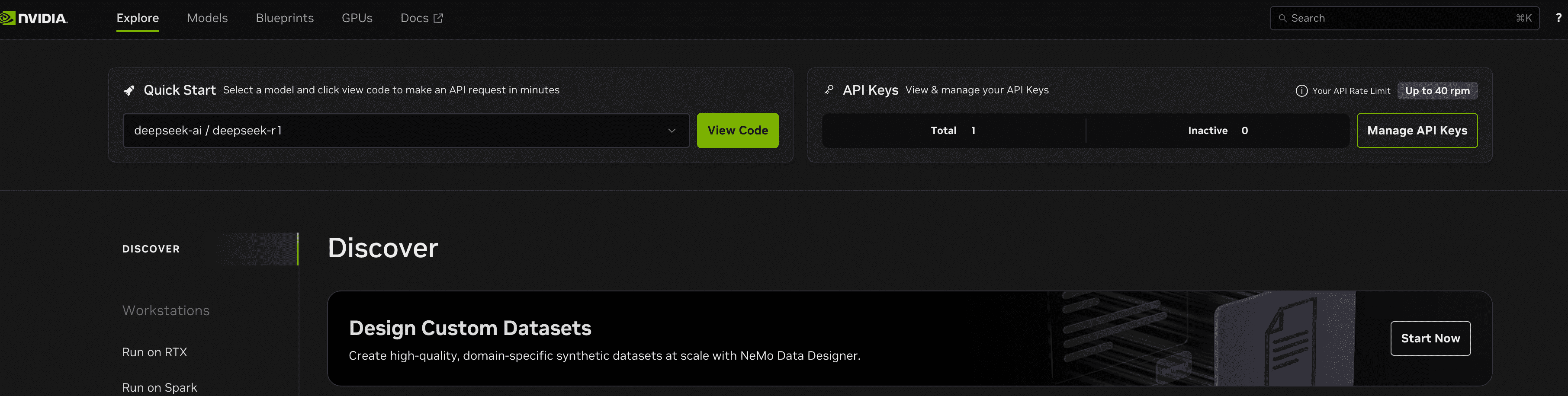

获取 API Key

- 访问 NVIDIA Build

- 注册/登录 NVIDIA 账号

- 在任意模型页面点击 “Get API Key” 获取

总结

NVIDIA NIM 作为一个模型聚合平台,持续在引入新模型。这次 GLM-4.7 和 MiniMax-M2.1 的免费开放,为开发者提供了更多选择。特别是 GLM-4.7 的 Coding 能力,非常适合日常开发辅助。

赶紧去试试吧!