背景

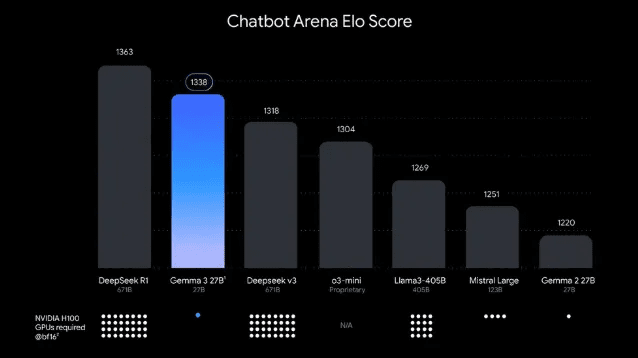

谷歌最近发布了 Gemma 3,这是其开源模型家族的最新版本,为 AI 行业带来了深远的创新。Gemma 3 凭借多模态处理能力、庞大的上下文窗口和增强的语言支持,标志着大型语言模型 (LLM) 发展的重要里程碑。该模型的开源特性为开发者和研究人员提供了前所未有的机会,可以在各种应用场景中探索和利用先进的 AI 能力。

谷歌最近发布了 Gemma 3,这是其开源模型家族的最新版本,为 AI 行业带来了深远的创新。Gemma 3 凭借多模态处理能力、庞大的上下文窗口和增强的语言支持,标志着大型语言模型 (LLM) 发展的重要里程碑。该模型的开源特性为开发者和研究人员提供了前所未有的机会,可以在各种应用场景中探索和利用先进的 AI 能力。

核心特点

多模态处理

Gemma 3 最突出的特点是其多模态处理能力,可以同等理解和关联文本、图像和视频。这使其特别适用于数据密集型领域,如医疗诊断、媒体内容分析和复杂科研应用。模型能够从多种数据源中提取信息并建立关联,为用户提供更全面的分析和洞察。扩展上下文窗口

另一个重要突破是上下文窗口的大幅增加,达到高达 128k 令牌。这一创新对需要处理长篇幅且连贯文本的应用尤为重要,如法律文档分析、学术研究或科学出版。与之前的模型相比,Gemma 3 在长文本理解和连贯性维持方面提供了显著改进,使其能够处理更复杂的信息流。全球化与多语言支持

Gemma 3 支持超过140 种语言,并配备了专为多语言优化的增强型新分词器,满足了全球 AI 模型使用需求。模型的可扩展性——从1B 到 27B 参数——凸显了其适应不同行业场景的灵活性。较小版本可在移动设备和边缘计算环境中高效部署,而较大模型则支持更复杂的企业级应用和研究需求。

Ollama 安装指南

要在本地运行 Gemma 3 模型,首先需要安装 Ollama,这是一个强大的本地 LLM 运行环境。以下是不同操作系统的安装步骤:本地安装测试