本文介绍了一个专门面向 DeepSeek R1 的 Java 集成方案 deepseek4j。它完整保留了模型的思维链能力,提供响应式流式处理,并通过 Spring Boot Starter 实现开箱即用。相比直接调用 API 或使用其他框架,deepseek4j 提供了更优雅的开发体验和更完整的功能支持。

一、为什么需要 deepseek4j?

1.1 现有框架的局限性

- 思维链内容丢失:R1 最核心的推理过程完全被忽略

- 响应模式不兼容:无法处理”思考在前、结论在后”的输出模式

- 参数限制:temperature、top_p 等关键参数设置失效

- 流式处理不完善:用户体验欠佳

- 完整支持 DeepSeek 独有的思维链和高级特性

- 支持 DeepSeek 联网搜索

- 提供 Project Reactor 的全面响应式支持

- 提供集成 Spring Boot Starter,提供自动配置

二、核心特性

- ✨ 完整保留思维链能力

- 🚀 响应式流式处理

- 🛠 简单优雅的 API 设计

- 📦 开箱即用的 Spring Boot 集成

- 💡 内置调试页面

- 🔍 详细的请求响应日志

- 🔧 灵活的代理配置

- ⚡️ 响应式编程支持

三、快速开始

3.1 添加依赖

3.2 配置参数

3.3 基础使用

3.4 进阶配置

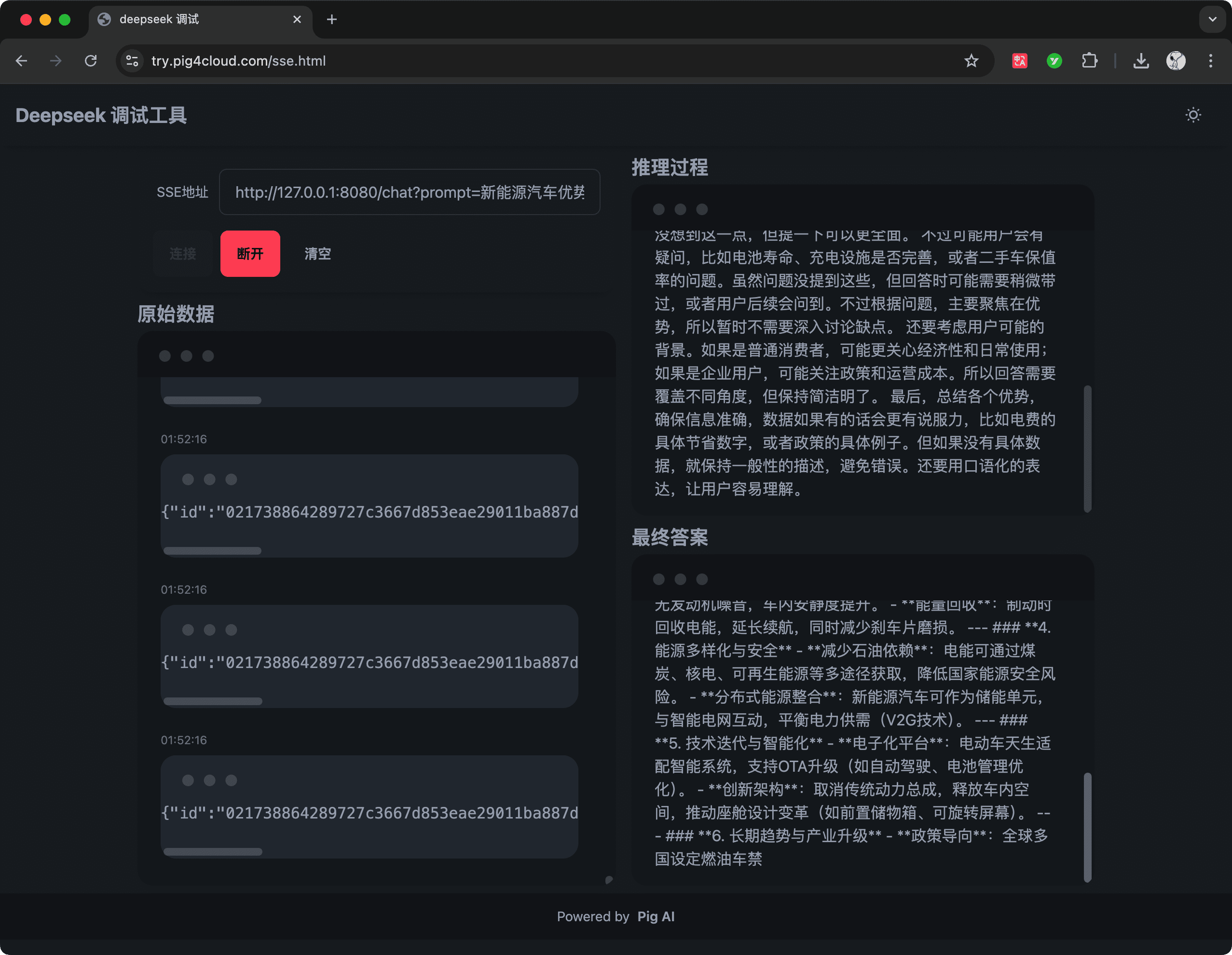

3.5 前端调试

双击运行根目录的 sse.html 文件,即可打开调试页面。在页面中输入后端 SSE 接口地址,点击发送后可实时查看推理过程和最终结果。页面提供了完整的前端实现代码,可作为集成参考。 欢迎关注公众号【JAVA架构日记】,获取更多 AI 开发实践干货!

欢迎关注公众号【JAVA架构日记】,获取更多 AI 开发实践干货!