随着大语言模型(LLM)的蓬勃发展,Java 开发者一直在寻找合适的工具来将 LLM 能力集成到自己的应用中。今天为大家介绍一个重量级开源项目 - Jlama,这是一个专为 Java 设计的现代化 LLM 推理引擎。

Jlama 是什么?

Jlama 是一个开源的大型语言模型推理引擎,专门为 Java 生态系统打造。它允许开发者直接在 Java 应用中运行 LLM 推理,无需依赖外部服务(比如 ollama 、vllm 等)。核心特点:

- 支持多种主流模型:Gemma、Llama、Mistral、Mixtral、Qwen2 等

- 基于 Java 20+ 构建,利用 Vector API 实现高性能推理

快速上手

1. 命令行使用

2. Java 项目集成

在 pom.xml 中添加依赖

代码示例

运行日志分享

特别说明

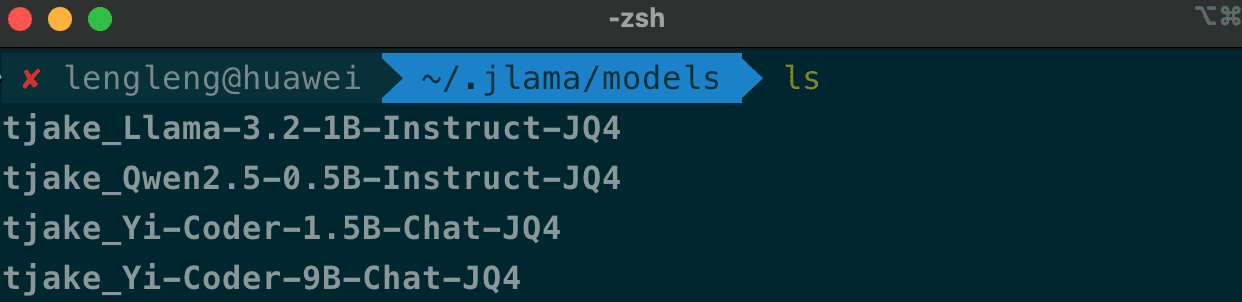

这里会实时去 huggingface 的下载模型文件,如果下载失败,可以手动下载,然后放到~/.jlama/models 目录下。

因为需要

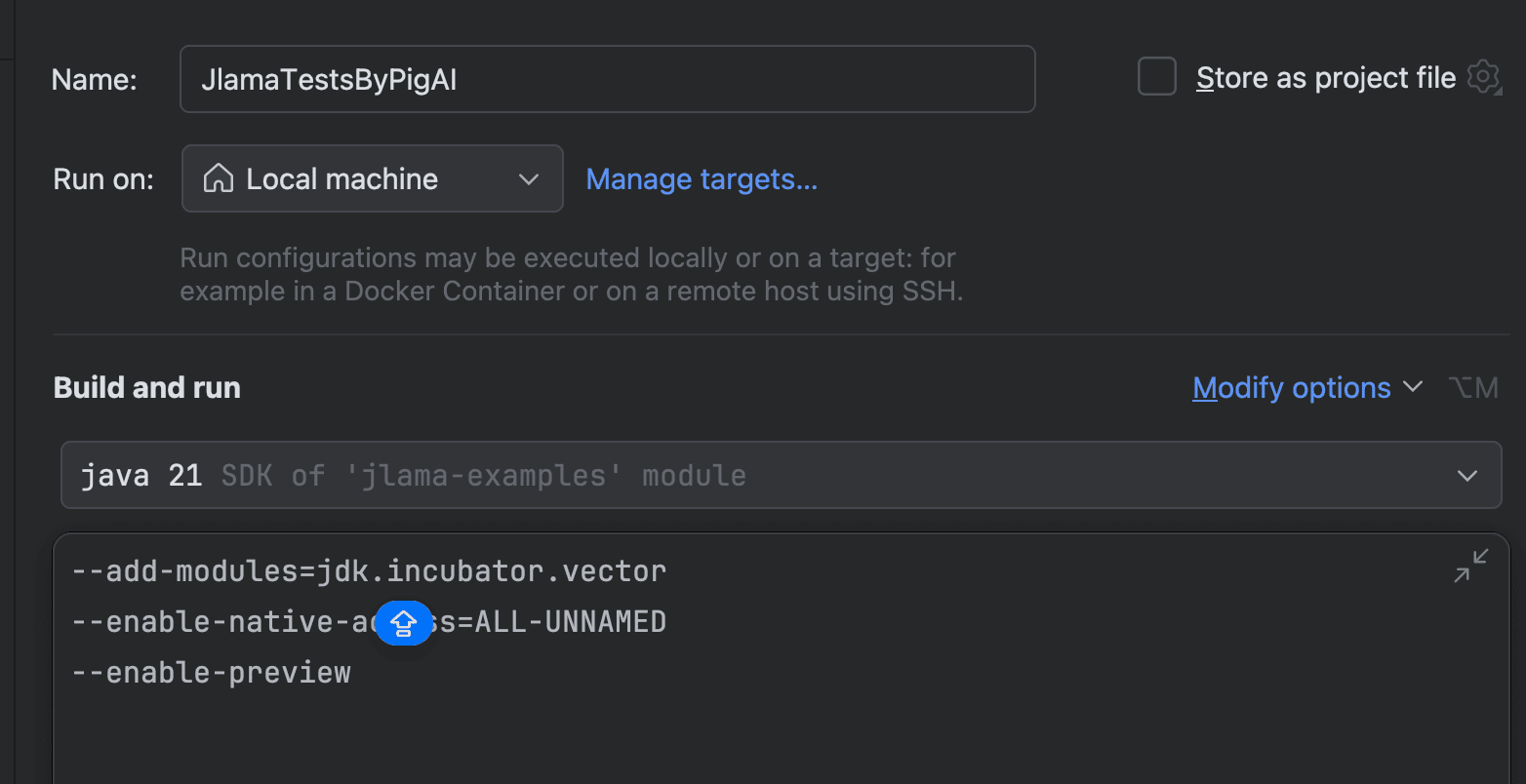

因为需要 jdk.incubator.vector 模块,所以需要使用 JDK20 及以上版本,并显示启用 jdk.incubator.vector 模块。